Une data fabric permet de démocratiser la donnée et de valoriser son usage au sein de l’entreprise

Les entreprises sont appelées à relever en permanence le défi de la performance et de la compétitivité. Un des leviers consiste à mieux gérer et exploiter les données, qui constituent une réelle richesse est un asset primordial des entreprises.

Nous avons accès aujourd’hui à un fort volume et à une plus grande variété de données provenant d’un plus grand nombre de sources. De même, nous disposons d’une importante diversité d’outils pour gérer, explorer, analyser ces données et en tirer des insights.

Jusqu’à présent les métiers fournissaient des exigences quant aux KPIs à construire, puis les équipes Data et IT concevaient, développaient, testaient, et déployaient les nouveaux indicateurs, les tableaux de bord ou analyses.

Avec des utilisateurs et consommateurs de plus en plus nombreux, des profils et des usages très différents, de nombreux outils ou langages variés. Mais aussi des difficultés d’accès aux données, une perception souvent trop technique des outils à disposition (notamment des utilisateurs les moins matures) l’enjeu aujourd’hui est d’optimiser le timing, la fréquence et la qualité du delivery des projets Data.

Pour répondre à cet enjeu, il faut pouvoir améliorer l’expérience utilisateur, faciliter l’accès aux données à tous les niveaux de l’entreprise, contribuer au développement des usages data et faire en sorte d’augmenter la productivité de chacun.

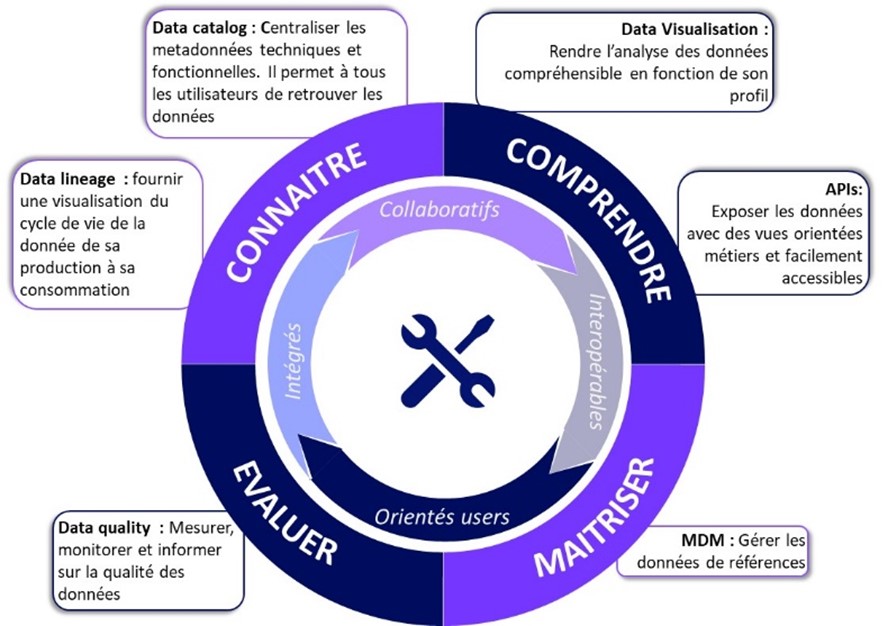

Un des leviers consiste à déployer une data fabric facilitant l’accès à des outils agiles, performants, interopérables et ergonomiques permettant de servir les besoins et attentes de chaque utilisateur. Qu’il soit gestionnaire ou consommateur de données.

Il s’agit d’un environnement constitué d’une architecture unifiée, proposant des services et technologies qui permettent aux entreprises d’optimiser la valeur et l’usage des données.

Une Data Fabric permet d’accéder, d’ingérer et de partager les données quels que soient les profils et les usages des collaborateurs (data scientist, data analyst, data engineer, directions métier…), tout en garantissant la disposition d’une même donnée référente :

- Se connecter à n’importe quelle source de données via des connecteurs et composants pré-assemblés, permettant d’offrir un accès en libre-service aux données dont les consommateurs ont besoin et d’en disposer librement

- Obtenir une vue à 360 degrés en temps réel et disposer d’un langage commun pour supporter les différents cas d’usage et favoriser le partage des données avec les parties prenantes internes comme externes

- Être capable d’intégrer plus facilement les données entre les sources de données et les applications

- Gérer plusieurs types d’environnements techniques comme le cloud on-premise, hybride ou le multicloud

- Automatiser la préparation des données pour limiter les tâches répétitives fastidieuses de transformation, de nettoyage et d’enrichissement des données

Précurseurs, la plupart des GAFAM ont déjà déployé des « Data Portal » ou des « Data Fabric ».

L’objectif étant de donner accès aux données à tous les niveaux de l’entreprise.

La plupart disposent de volume de données très important (+200K tables dans leur base par exemple pour l’un d’entre eux), ce qui implique de très grosses difficultés pour trouver l’information. Seuls quelques utilisateurs avertis pouvaient naviguer dans les bases de données.

AirBnB a par exemple, développé un outil interne : DataPortal, qui permet de rechercher l’information avec un moteur de recherche de type google, de la restituer sous forme graphique à n’importe quel employé, ainsi que la restitution des métadonnées contextualisées (pas les mêmes informations remontées selon les profils).

Des projets également menés en France, par exemple chez un leader du secteur bancaire.

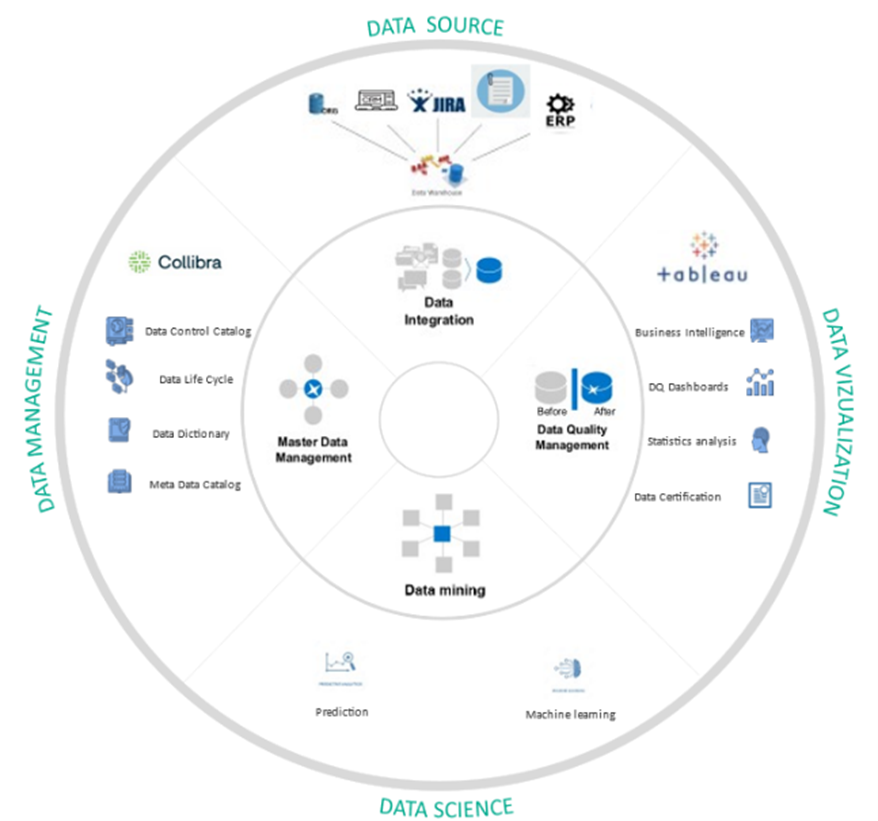

Une grande banque française qui souhaitait faire bénéficier ses collaborateurs d’une meilleure gestion et compréhension des données consommées, a mis en place un Data Portal qui intègre l’outil de data visualisation Tableau à l’outil de data gouvernance Collibra.

Ils ont fait le choix d’adopter un outil d’analyse et de BI en libre-service pour apporter de plus grandes capacités d’analyse et de reporting aux différents types d’utilisateurs.

L’objectif de ce portail Data est d’associer l’efficacité des analyses des outils d’analyse et de viz, à la transparence et à la confiance que le logiciel de data catalog apporte aux données. Grâce à cette intégration, les utilisateurs peuvent plus facilement localiser et analyser les rapports et tableaux de bord, ainsi que suivre directement les sources et le lignage des données sous-jacentes pour obtenir une image plus complète des informations.

Pour tirer le meilleur parti des analyses, ils doivent savoir où trouver les meilleures données, comprendre leur contexte et avoir confiance en leur exactitude. Grâce à l’interopérabilité entre les deux outils, les collaborateurs peuvent rechercher et collaborer sur des ensembles de données et des rapports créés dans Tableau.

Les utilisateurs de Tableau ont la possibilité de socialiser et de collaborer sur des rapports certifiés, ce qui leur permettent d’accélérer le temps nécessaire pour obtenir des informations.

La combinaison de Collibra et Tableau offre une combinaison transparente d’une base de données fiable et d’outils permettant de découvrir des informations de manière créative, de la découverte des données à leur visualisation et leur analyse.

Avec ce portail data, il s’avère qu’il est devenu plus simple de travailler sur des sujets de data science & ML puisque la disponibilité des données de bonne qualité est assurée.

Aujourd’hui ce portail data permet aussi aux data scientists de gagner énormément de temps et d’instaurer de la confiance sur la nature des algorithmes conçus.

Les utilisateurs finaux peuvent prendre en main l’outil de data visualisation, et ainsi s’en servir pour faire du self-service BI sans se soucier des bases de données.

Les corrections d’anomalies sont prises en charge rapidement par les concepteurs des dashboards grâce aux notifications déclenchées sur la marketplace par les utilisateurs finaux.

Les reporting sont bien exploités, assimilés et analysés par l’ensemble des utilisateurs à travers les commentaires sur la marketplace.

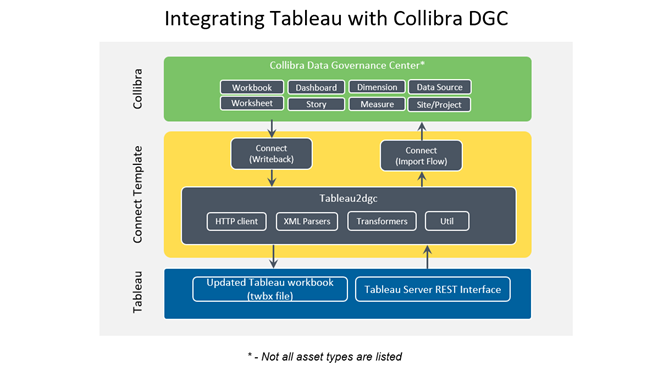

L’intégration Tableau et Collibra :

Source : Collibra

L’intégration Collibra-Tableau charge les ressources de Tableau dans la DGC de Collibra. Les API REST de Tableau sont utilisées pour extraire les ressources de Tableau telles que Workbook, Dashboard, Worksheet, Story, etc. et les relations qui les soutiennent.

En outre, les attributs de rapport des feuilles de travail sont chargés avec leur relation aux dimensions (attributs dimensionnels) et aux mesures.

Les sources de données relationnelles (publiées et non publiées) et les sources de données Excel (uniquement publiées) sont prises en charge, c’est-à-dire que leurs métadonnées sont chargées dans Collibra DGC afin de fournir un lien de bout en bout entre l’attribut du rapport et son champ/colonne source dans les sources de données. Ces métadonnées sont récupérées à partir de Tableau.

Les principales caractéristiques sont les suivantes :

- Tableau Logical Data Layer : Dans le catalogue Collibra, les utilisateurs peuvent maintenant voir directement les sources de données sous-jacentes et le cheminement des rapports Tableau, ce qui les aide à obtenir une image plus complète, à évaluer et à atténuer les problèmes potentiels de qualité des données, et à mieux comprendre le contexte nécessaire pour produire des analyses et des décisions commerciales plus éclairées.

- On-the-Go pour Tableau : Le widget On-the-Go de Collibra utilise l’API Tableau Extensions pour permettre aux utilisateurs d’accéder à Collibra au sein de leurs tableaux de bord Tableau existants, répondant ainsi aux utilisateurs professionnels là où ils se trouvent et les aidant à ne pas avoir à changer de plateforme dans leur travail. Le widget On-the-Go crée un emplacement central pour les données et les analyses, et fournit aux utilisateurs professionnels un accès mobile pratique qui les aide à obtenir des réponses rapides à leurs questions sur les données.

- Assemblage automatique : les utilisateurs peuvent désormais créer des liens entre les bases de données et les sources de données Tableau, qui assemblent également automatiquement tous les éléments de données contenus. Cela permet d’établir automatiquement des liens de bout en bout entre les bases de données et les rapports, ajoutant ainsi un élément crucial de confiance et de contexte pour les utilisateurs qui cherchent à comprendre les données et à en tirer de nouvelles informations.

- Nouvelle recherche : La nouvelle fonctionnalité de recherche de Collibra Catalog utilise l’intelligence artificielle pour tracer les données liées entre les systèmes et les départements grâce à un glossaire commercial étendu. La fonction de recherche améliorée permet même aux utilisateurs fonctionnels de découvrir rapidement les bonnes données, sans avoir besoin de savoir comment et où elles sont stockées. Il comprend également des fonctionnalités sociales, telles que l’enregistrement et le partage, pour faciliter une meilleure collaboration.

Comme nous le voyons à travers ce use case, l’interopérabilité entre les différents outils data est l’une des clés de la réussite des projets data et de l’ancrage des usages data dans l’entreprise.

Pour en savoir plus sur Tableau, vous pouvez consulter cet article rédigé par un de nos experts en Data Analysis.